Por Carlos L. Vilchis, Miguel González-Mendoza, Leonardo Chang

Si tuvieras que recordar la interacción que experimentaste entre tu computadora y las necesidades que resolviste en línea durante la cuarentena del COVID-19, ¿qué mejorarías? El comercio electrónico, la atención al cliente o soporte técnico remoto recibieron la prueba más dura durante esta contingencia en el 2020. Desde las soluciones basadas en videoconferencia, el enrutamiento de llamadas por callcenter, la logística de reparto hasta los chatbots en línea, formaron parte del conjunto de soluciones para atender nuestras necesidades a través de dispositivos en línea. Particularmente este último recurso; los asistentes de chat basados en texto, han sido los más utilizados, en donde vimos todo un repertorio de herramientas y algoritmos basados en Artificial Intelligence (AI) para poder interactuar con nosotros a través de un chat de texto.

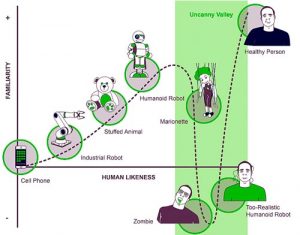

Sin embargo, esto no fue suficiente. El ser humano por naturaleza está habituado a hablar y sentir una mayor empatía a través de otra entidad que simula ser un ser humano. Si bien en el pasado los humanos hemos tratado de generar una conexión emocional con los robots, se presenta una barrera que evita lograrlo de manera exitosa, fundamentado en un concepto llamado «Uncanny Valley», propuesto por Masahiro Mori en 1979. Muchos ejemplos se pueden mencionar de robots o androides que a fines de la década pasada intentaron robar nuestra atención, pero seguía existiendo esa «incómoda» sensación de hablar con algo que no era lo suficientemente humano o empático para construir un vínculo como el que construyes con un amable y sonriente empleado en una tienda departamental.

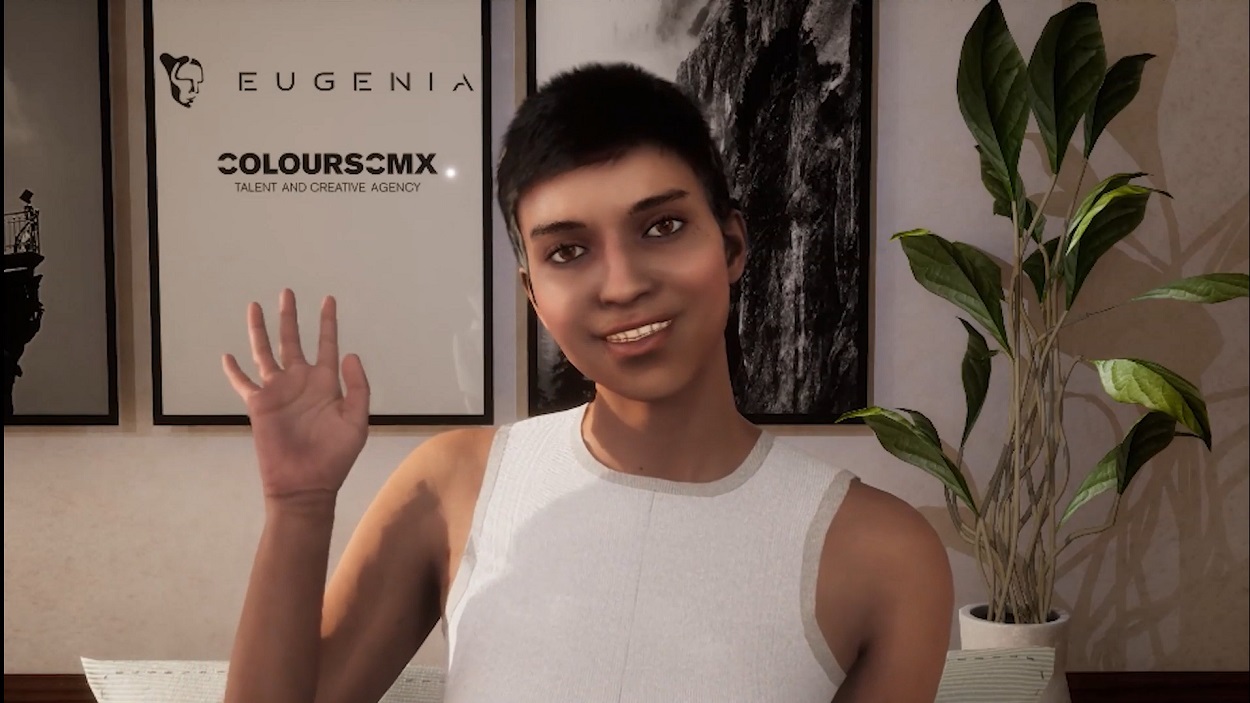

Por esta razón, en los últimos años la cantidad de investigación centrada en este modelo, conocido como la relación humano-computadora (Computer Human-Interaction) a través de la representación de un «avatar» fotorrealista, inteligente y empático, dio como resultado la convergencia de tecnologías en ciencias computacionales que ahora conocemos como humanos digitales. Por un lado, los computer graphics han tenido una evolución acelerada gracias a la industria interactiva de los videojuegos, el VR/AR, los gráficos en tiempo real empleados en la industria del entretenimiento en general, y por el otro lado, la Inteligencia Artificial (AI) como la disciplina que ha permitido solucionar operaciones y cálculos lógicos de gran escala a través, particularmente, del Aprendizaje de Máquinas (Machine Learning), que permite extraer información a partir de un conjunto de ejemplos sin necesidad de que un humano tenga que darle una solución u opción a la infinidad de circunstancias a las que se enfrente.

¿Qué elementos componen a un humano digital?

Entendamos que la suma total de estas tecnologías, métodos y aplicaciones son, por el momento, prototipos funcionales de lo que hace a un humano digital tener vida. A esto lo conocemos como un framework, pues propone una solución integral que comprende desde la creación del humano hasta su interacción mediante técnicas de gráficos computacionales, hasta su interacción en vivo con otros seres humanos utilizando visión computacional (computer vision), que es un subconjunto de la inteligencia artificial que busca entender y automatizar tareas relacionadas a observar el entorno. Panorama difícil de entender, ¿cierto? Procedamos a explicar paso a paso el estado del arte de los humanos digitales.

Modelo de un humano 3D fotorrealista

Los modelos 3D que representan humanos fotorrealistas ha sido un tema de investigación durante los últimos 30 años desde el primer Andy que vimos en Toy Story en 1994, hasta los personajes realistas de la última entrega de The Last of Us 2 en el Playstation 5. La industria de los gráficos computacionales se ha apoyado en el research tecnológico que año con año ayuda mediante nuevas técnicas computacionales, como la reconstrucción de escaneo 3D de humanos por fotogrametría polarizada, técnicas de rendering en real time para piel humana realistas, iluminación y reflejos basados en raytracing computacional, hasta la simulación de ropa y cabello mediante física y colisiones.

Actualmente la solución más adecuada para crear un humano digital realista es a partir de otro humano real, es decir, la ingeniería inversa; y requiere que la persona que cede su imagen permite la digitalización de decenas de expresiones de su rostro para describir el desempeño de los músculos de la cara. A esta lo conocemos como «codificación facial» y un método muy realista es la codificación Facial Actor Code System (FACS), el cual proviene de un estudio desarrollado por el Dr. Paul Ekman hace 3 décadas, y que permitía desarmar nuestro rostro, como si se tratase de un juego de Lego, a fin de poder conocer todas las combinaciones que existen de nuestras cejas, pómulos, labios y ojos. De esta manera, la gran cantidad de información proveniente de un rostro y sus diferentes combinaciones pueden ser analizados, combinados y reconocidos en vivo mediante técnicas de Aprendizaje Máquina y visión computacional para conocer con precisión el rostro de este humano real y transferirlo al humano digital.

Sistema de animación corporal/facial

Comprender el comportamiento real de un humano, es clave para poder representarlo en un humano virtual. Una de las maneras de adquirir esta información de nuestro desempeño corporal, es a través del Motion Capture. Hemos visto en infinidad de «making of» de películas cómo los actores actúan con trajes negros con pequeñas esferas blancas. Así como utilizar unos cascos con cámaras que registran el movimiento de sus rostros todo el tiempo. La adquisición de nuestros movimientos se ha llevado casi 2 décadas de investigación a través de métodos basados en reconstrucción infrarroja (esas pequeñas bolitas blancas son para reflejar esta luz) o trajes con sensores magnéticos/inerciales idénticos a los que utilizan los smartwatches para medir nuestra actividad en el gimnasio.

Por otro lado, están todas aquellas tecnologías utilizadas para entender nuestro rostro. Ejemplos claros son las cámaras que no solo capturan imagen, sino evalúan la profundidad (RGB-Depth), justo tal como lo hace la cámara de tu iPhone mediante Apple FaceID. De esta forma es posible obtener cada detalle, inclusive la deformación que nuestro rostro genera de una manera volumétrica-3d, y transferir de manera eficiente la forma que nuestro rostro genera las combinaciones de ese juego de «lego» antes mencionado, que son conocidos como Emotional FACS (emFACS): Feliz, triste, asustado, sorprendido, asco, neutral y enojo.

Interacción en vivo

Hemos hablado de cómo darle «cuerpo» y «comportamiento» a ese humano digital a través del modelo 3D y el motion capture a través de una gran cantidad de métodos computacionales. Pero llega el momento de darle un «habla y alma», el cual es un componente crucial en el último paso de un framework de humanos digitales: la entrega o performance.

Sabemos claro que interactuar con una computadora se volvió algo cotidiano desde hace un par de años gracias a los dispositivos Alexa y el asistente Siri en nuestros teléfonos, pero entender la manera en la que los humanos nos comunicamos a través del lenguaje, la construcción de oraciones y el sentido que estas tienen se logra mediante un método llamado Natural Language Processing (NLP), así como es posible que la computadora entendiendo nuestras solicitudes (Natural Language Understanding) y genere para nosotros respuestas coherentes de la manera más adecuada posible (Natural Language Generation). Todos estos métodos de lenguaje requieren del uso de algoritmos y métodos para procesar ese «habla», que surge como la solución más objetiva para articular la boca de los humanos digitales. En efecto, Siri o Alexa, tarde o temprano tendrán un rostro con el cual interactuaremos.

Conclusión

Entender la manera correcta en la que los humanos nos sentimos cómodos con una instancia digital, ya sea que construyamos una relación empática, amable y cómoda, nos sintamos atraídos por su aspecto físico, por el comportamiento con el que se mueve mientras habla con nosotros o si somos capaces de creerle o sentir que miente, es uno de los retos más grandes de la investigación en percepción aplicada en la interacción humano-computadora.

El poder desarrollar frameworks de trabajo, mucho más estandarizados, homologados y abiertos para cualquier investigador, es parte del reto que existe en la investigación y desarrollo de las Ciencias Computacionales a través del Machine Learning, Computer Vision y Computer Graphics. De esta manera, cualquier persona como un emprendedor o estudiante podrá construir humanos digitales realistas, empáticos y que ayuden a nuestra sociedad digital a mejorar la manera en la que integramos los humanos digitales en nuestras vidas.

Este proyecto es un patio de experimentación de la empresa Eugenia, la cual es la primera empresa de humanos digitales en habla hispana y recientemente ganó una convocatoria en Estados Unidos con un premio de 60 mil dólares.

Autores

Carlos Vilchis

Empresario, Ingeniero y Maestro. Director en Tecnología. Estudió una maestría en Animación 3D en España, Madrid, a su regreso trabajó en Televisa, Genoma Lab , UVM y Universidad Anáhuac, universidades bajo las cuales colaboró para diseñar programas de licenciatura enfocados a gráficos en 3D y videojuegos. Hoy en día estudia un Doctorado en Ciencias Computacionales en el Tecnológico de Monterrey. Actualmente es socio fundador y Director de Tecnología y Research de Eugenia Digital Humans, la primera empresa de humanos digitales en habla hispana.

Miguel Gonzalez-Mendoza

Posee el grado de PhD y un postdoc en Inteligencia artificial por la INSA y LAAS-CNRS Toulouse, France en 2003 y 2004 respectivamente. Tiene 15 años de experiencia en investigación en el Tecnológico de Monterrey enfocado en Machine Learning, semantic web y big data. Fue presidente de la Sociedad Mexicana de Inteligencia Artificial del 2017-2019. Es miembro del Sistema Nacional de Investigadores (SIN) nivel II.

Leonardo Chang-Fernandez

Es originario de La Habana, Cuba recibe su y Ph.D. en Ciencias de la Computación del Instituto Nacional de Astrofísica, Óptica y Electrónica (INAOE) de México en 2010 y 2015, respectivamente. Fue Investigador en CENATAV, Cuba durante 2007-2015, y Jefe del Grupo de Reconocimiento Facial de la misma institución de 2015 a 2017, donde dirigió y contribuyó a investigaciones aplicadas para sistemas comerciales de reconocimiento facial. Actualmente, es Profesor Investigador de tiempo completo en el Tecnológico de Monterrey, así como miembro del Sistema Nacional de Investigadores, nivel C. Sus intereses de investigación incluyen biometría (principalmente enfocada al reconocimiento facial), reconocimiento de objetos y aplicaciones de videovigilancia.