Un turista maorí escucha el saludo: “Kia ora, nau mai kit o hotera”. Es la voz de un androide en el check in del Wierd Hotel, en Japón. Dotado de inteligencia artificial (IA), conoce todos los idiomas y los adapta sin dificultad a la nacionalidad de cada huésped.

“¡Imagínate lo que costaría conseguir un recepcionista humano con esas capacidades!”, dice Enrique Cortés Rello, profesor en la Escuela de Ingeniería y Ciencias del Tecnológico de Monterrey y director del hub de IA del Tec Campus Guadalajara.

“La previsión es que, en los próximos tres a 10 años, los sistemas autónomos crucen la raya y desempeñen su trabajo mejor que nosotros”.

No hay marcha atrás. Una nueva forma de inteligencia no humana que supera con mucho nuestras capacidades de cómputo y de memorización, ha penetrado de forma silenciosa, pero implacable, en todos los aspectos de la civilización.

Eso ya se mira en algunas tareas: jugar póker, conducir un coche de forma segura, hacer diagnósticos médicos a partir de radiografías o realizar predicciones financieras.

Pero, ¿hasta dónde debemos dejar que domine nuestras vidas? ¿existen riesgos de la Inteligencia Artificial? ¿Es posible domesticarla para que respete el libre albedrío y otros derechos civiles de las personas?

Las riesgos de la Inteligencia Artificial

“Lo que dirige nuestras vidas no son los algoritmos, es la gente que hay detrás de los algoritmos”, advierte Luciano Floridi, profesor de Filosofía y ética de la Información en el Oxford Internet Institute de la Universidad de Oxford.

Asegura que tan solo unas pocas compañías, que se pueden contar con los dedos de la mano, fabrican y proveen la mayoría de aplicaciones y herramientas de IA en el mundo.

“Si no somos precavidos con la legislación, será difícil velar por que esta gente haga lo correcto. La competencia de mercado ayuda a que una actividad se autorregule y adapte a las necesidades de la gente. Pero si dejamos que esté en manos de un monopolio, sería un verdadero desastre”, señala Floridi.

La IA es una herramienta muy poderosa que puede traer grandes beneficios a la sociedad, pero también puede exacerbar riesgos.

La misma inteligencia artificial que se emplea para detectar fraudes informáticos es aprovechada por el cibercrimen para violar nuestra identidad o robar nuestras credenciales de banca online.

Y los mismos sistemas de reconocimiento facial que se emplean para prevenir delitos pueden suponer una violación de nuestro derecho a la privacidad.

Aunque, quizá, una de las amenazas más sofisticadas consiste en las nuevas estrategias de manipulación personalizada.

“La tecnología de redes neuronales es muy eficiente a la hora de predecir el comportamiento humano y explotar sus deseos y necesidades. Puede saber lo que deseamos antes de que nosotros mismos lo sepamos. Es un verdadero peligro para nuestra capacidad de decisión autónoma”, advierte Luciano Floridi.

La manipulación basada en Big Data

Dipayan Ghosh y Ben Scott, investigadores de la Harvard Kennedy School y autores del informe Digital Deceit, reconocen que “los sentimientos individuales sobre ideas o candidatos políticos suelen ser muy impresionables y, por lo tanto, manipulables”.

La propaganda de precisión está basada en las mismas técnicas de IA que usa el marketing online.

“Las herramientas de publicidad digital, perfectamente legales, han desarrollado estrategias brillantes de persuasión activa. Pero también han abierto la puerta a muchos abusos que pueden dañar el interés público y la cultura política, debilitando la integridad de la democracia”, dice Ghosh, consejero de tecnología en la Casa Blanca durante el mandato del expresidente de EU, Barack Obama.

Agrega que que experimentamos ya “la era de la desinformación algorítmica”.

Lo peor que nos puede pasar no es la influencia sobre nuestra decisión de compra, sino la manipulación de nuestras creencias, nuestro sentir político y social. La manipulación de nuestra visión del mundo.

Bots, microsegmentación de la población y mensajes diseñados a medida para cada perfil son algunas de las armas en el arsenal de la propaganda de precisión.

Otra es el filter bubble: los algoritmos “encierran” a la persona en una burbuja, dentro de la cual se refuerza continuamente un único punto de vista (con las noticias que recibe en su feed, los resultados de sus búsquedas en Google, etcétera), haciendo desaparecer cualquier argumento que pueda rebatirlo. Es una de las estrategias del Social Media Management Software (SMMS), que se ocupa de determinar qué grupos de personas son más adecuados para dirigirse a ellos (para que compren un producto o voten por un candidato político, por ejemplo). Para dibujar perfiles, los algoritmos del SMMS se alimentan del Big Data.

“La huella que dejamos atrás en cada paso que damos en internet. Se estima que, por cada individuo en Estados Unidos, hay 5,000 puntos de datos disponibles para el análisis”, señala Martin Hilbert, profesor de Comunicación en la Universidad de California y asesor tecnológico de la Biblioteca del Congreso de Estados Unidos, en una charla TED.

Cada publicación, cada foto, cada opinión que tuiteamos, las cookies que delatan qué páginas web hemos visitado… Todo va dejando una pista de cuál es nuestro talón de Aquiles.

Floridi considera esencial educar a la población sobre cómo funcionan estas sofisticadas herramientas para orquestar la opinión pública, a fin de que seamos más críticos y conscientes a la hora de filtrar la información que recibimos y tomar decisiones.

El sesgo del algoritmo

Por otra parte, está el problema de los sesgos, es decir, los prejuicios de género, estatus socioeconómico, religión, preferencias sexuales, edad, color de piel… que se ven amplificados por los programas de machine learning.

En su análisis del sesgo de género de la IA, la UNESCO denuncia que “el mundo digital replica los estereotipos y prejuicios que dominan la vida real”. ¿De quién es la culpa?

“Imagina que el programador hace un buen trabajo y diseña un código de IA excelente para hacer determinada tarea. Luego hay que alimentarlo con datos para que ese software empiece a aprender. Si esos datos están sesgados, es cuando aparece el problema”, dice Cortés Rello, académico del Tec de Monterrey.

Floridi dice que la IA funciona como un microscopio de la sociedad.

Por ejemplo, imaginemos que tenemos un software de recursos humanos y lo alimentamos con los datos históricos de una empresa.

Luego, si ese programa elige solamente a candidatos masculinos, es porque está replicando lo que se había estado haciendo durante décadas en la compañía. Pero ¿qué ocurre cuando el sistema aprende del medio ambiente, sin que nadie pueda arbitrarlo?

El caso de YouTube fue puesto en evidencia por uno de sus exempleados, Guillaume Chaslot, quien denunció que el algoritmo que usa para recomendar videos tiene un sesgo hacia contenidos violentos, sensacionalistas o morbosos.

“El software da prioridad a los videos que captan más la atención de los usuarios, por encima de cualquier consideración ética”, dijo Chaslot.

Google también tiene mucha experiencia en la materia. En 2015, puso en marcha su software de etiquetado automático de imágenes, que aprendía de la forma en que los usuarios le ponían un tag sus fotos.

El resultado fue que dos personas de piel oscura aparecieron identificadas como “gorilas”.

“Aquí no hubo intento malicioso de discriminar. La culpa fue de un algoritmo malhecho. Para evitar que pasen estas cosas, debe haber un control de calidad humano. No puedes solo soltar a los algoritmos, ahí por el mundo y ver qué hacen”, recalca Cortés Rello.

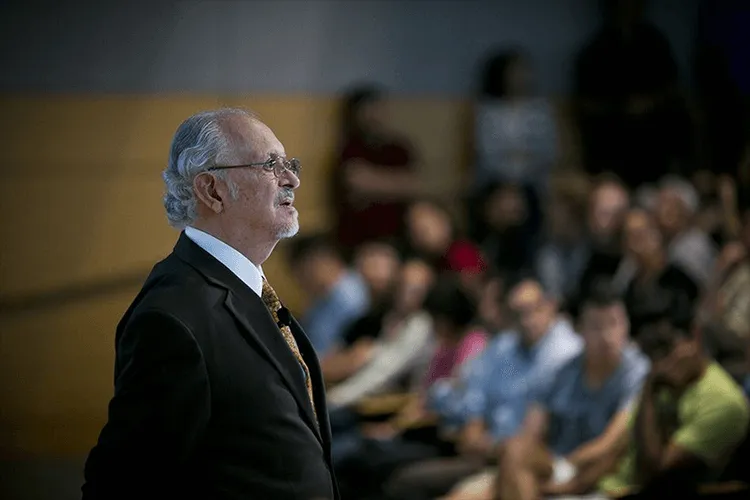

Ramón López de Mantarás, fundador del Instituto de Investigación en Inteligencia Artificial del Consejo Superior de Investigaciones Científicas, en España, y coautor de la Declaración de Barcelona para un desarrollo y uso adecuados de la inteligencia artificial en Europa, advierte que “el hecho de que estas tecnologías sean ajenas a los valores y necesidades humanas nos debería hacer reflexionar sobre aspectos éticos en el desarrollo de la IA y, en particular, sobre la conveniencia de dotar de total autonomía a las máquinas”.

A pesar de ello, estas son las formas de IA que se usan cada vez más. “Se diseña un sistema y luego se entrena para que aprenda por sí mismo. A veces, incluso, se autoentrenan. Y, cuando repiten una tarea el número suficiente de veces, llegan a hacerla mejor que un humano, es cierto, pero solo puede hacerlo con esa tarea”, explica Cortés Rello.

Es decir, un software que juega al ajedrez nunca podrá aprender a jugar al póker.

Frente a este escenario, la UNESCO presentó en 2021 el Proyecto de Recomendación Sobre la Ética de la Inteligencia Artificial que contempla los principios de tecnologías como reconocimiento facial.

“Legislación, educación, ética y competitividad de mercado”, son −de acuerdo con Floridi− las cuatro patas de la mesa que se requieren para que la IA no nos desborde.

“La IA no existe por sí misma. Un humano tiene que programarla, entrenarla, para que aprenda y darle uso. Depende de nosotros lo que hagamos con ella. Puede ser una fuerza positiva para lidiar con las crisis económicas, el cambio climático, la pandemia. Pero tenemos que ser vigilantes desde las instituciones democráticas para que las grandes compañías que la fabrican y la implementan vayan en la dirección adecuada. Si todo ese software está mal diseñado, entrenado o usado, puede ser muy peligroso. Estamos a tiempo de arreglarlo, pero si dejamos que siga creciendo y no hacemos nada, dentro de cinco o 10 años será mucho más difícil tomar las riendas”.