Al ser una creación humana, la Inteligencia Artificial (IA) puede reproducir y amplificar los sesgos que prevalecen en nuestras sociedades hacia las mujeres, según explican especialistas en estas tecnologías.

De acuerdo con la Organización de las Naciones Unidas para la Educación, la Ciencia y la Cultura (UNESCO), las mujeres tienen 25% menos probabilidades que los hombres de saber cómo aprovechar la tecnología digital. Por otro lado, solo 12% de los investigadores en Inteligencia Artificial y 6% de los desarrolladores de software son mujeres.

En México, solo el 31% de las estudiantes de ingeniería son mujeres. Además, únicamente el 12% de la fuerza laboral STEM (Ciencia, Tecnología, Ingeniería y Matemáticas, en inglés) y tan solo el 10% de los programadores son mujeres.

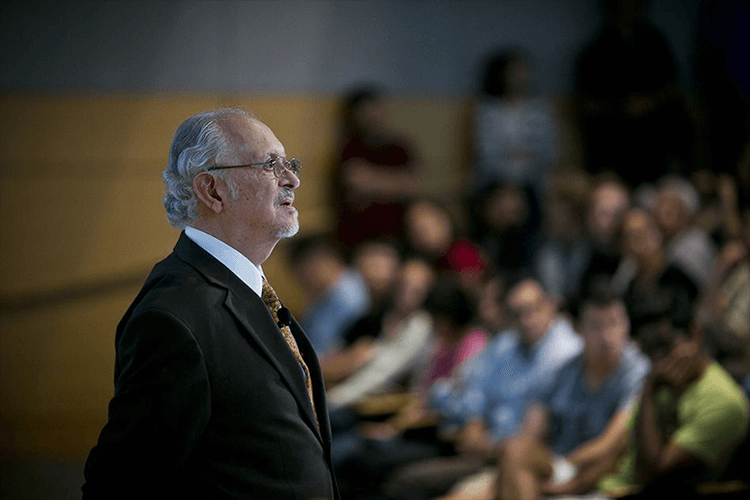

“La Inteligencia Artificial plantea un crecimiento inimaginable, es mandatorio que las mujeres participemos”, dijo Patricia Chávez, directora regional del Departamento de Computación del Campus Ciudad de México, en el panel Mujeres en la ciencia. IA: un futuro diverso e inclusivo llevado a cabo en el Tec Science Summit 2024 del Tec de Monterrey.

Este fue moderado por Teresa Barragán, gerente nacional de Comunicación Institucional del Tec de Monterrey, y contó con la participación de Chávez, Linda Medina, directora de División de la Escuela de Ingeniería y Ciencias, Lourdes Martínez, profesora investigadora de la Universidad Panamericana y presidenta de la Sociedad Mexicana de Inteligencia Artificial y Enrique Cortés, director del Hub de Inteligencia Artificial del Tec de Monterrey.

La falta de representación y participación en el desarrollo de estas tecnologías es uno de los motivos por los cuales pueden existir sesgos hacia las mujeres, pero también pueden venir de los datos que se usan para entrenar a las IA.

“Muchas veces los datos no son representativos de la población”, dijo Cortés.

Sesgos en la Inteligencia Artificial

Para evitar que se reproduzcan o generen sesgos hacia las mujeres y otros grupos subrepresentados en la IA existen distintas medidas que se pueden tomar.

La primera es fijarse muy bien en los datos y en el modelo, incorporando perspectivas y muestras representativas. Contar con un equipo diverso y multidisciplinario que participe en todos los pasos de la creación del algoritmo o sistema es esencial para lograrlo.

“La manera más efectiva de mitigar estos sesgos es cacharlos desde la conceptualización del sistema”, dijo Cortés.

Uno de los ejemplos del impacto de estos es el de Joy Buolamwini, una informática afrocanadiense que descubrió que distintos softwares de reconocimiento facial, así como robots sociales no reconocían su cara.

Al percatarse de esto, empezó a indagar y encontró que el algoritmo que estaba detrás de los softwares y robots había sido entrenado con imágenes de rostros blancos, por lo que era incapaz de reconocer otros.

Con base en su experiencia, Buolamwini lanzó la Algorithmic Justice League, una organización dedicada a combatir la discriminación en estas tecnologías.

“Necesitamos auditar y probar los algoritmos para detectar si hay algún sesgo”, dijo Chávez.

Por ello, es crucial contar con un mayor número de mujeres expertas en programación, para aumentar la diversidad entre las personas que escriben código, pero también para crear equipos de expertos y expertas que se dediquen a examinar los algoritmos y asegurarse de que sean representativos.

También, es importante alzar la voz y reportar o hacer notar cuando detectemos que existe un sesgo o un prejuicio en un algoritmo o programa de IA.

“Eso sirve, aunque pensemos que no”, dijo Medina.

Escuelas y universidades tienen un rol crucial

Además, es indispensable que en las escuelas se cuente con programas de enseñanza de IA que incluyan un apartado específico sobre ética y diversidad, donde se propicie la diversidad de pensamiento, aprendiendo a escuchar e incorporar lo que todos y todas tienen que decir.

“No es solo que de repente salió en las clases y se platicó, hay que preparar un módulo y hacer que los y las estudiantes participen”, dijo Medina.

También es importante que, desde pequeñas, las niñas sepan que pueden dedicarse a las matemáticas y programación si eso quieren hacer, acercándoles la IA de una forma compatible con su edad.

“En Coursera, en los últimos tres años han pasado del 30% al 50% las inscripciones de mujeres en cursos de IA”, contó Medina.

Las empresas, organizaciones e instituciones que hagan uso de la IA deben contar con códigos de ética claros que guíen a los usuarios y creadores de algoritmos para utilizarlos y hacerlos de manera incluyente.

“Creo que hay que hablar y educarse en estos temas, contar con guías prácticas que nos ayuden a evaluar los impactos y riesgos de las IA”, dijo Martínez.

Esto es especialmente importante, porque el uso de estas tecnologías ha aumentado de manera exponencial, mientras que la legislación y regulación de las mismas se ha quedado atrás.

“En lo que hay ley, nosotros, los constructores de sistemas tenemos que estar al tanto de estos riesgos y mitigarlos”, dijo Cortés.

Por último, es importante entender que estos prejuicios son parte de la condición humana y que no significa que estén ahí porque tenemos malas intenciones.

“Cada uno de nosotros tenemos sesgos y vamos a cuidar al grupo al que pertenecemos, por eso es importante que haya representatividad de todos y todas”, concluyó Martínez.